データ統合とは?その必要性と具体的なステップ、

よくある課題と解決案をご紹介

データ統合は自社の異なるシステムに蓄積された情報を一元化・可視化し、効果的なデータ分析を実施するうえで不可欠のプロセスです。データ統合を行うことで、業務効率化やサイロ化の解消などを進めることができます。本記事では、データ統合の必要性やメリット、課題、具体的なステップについて解説します。

- 目次

- お役立ち資料

- データ分析基盤構築ガイドブック

データ統合とは?その必要性

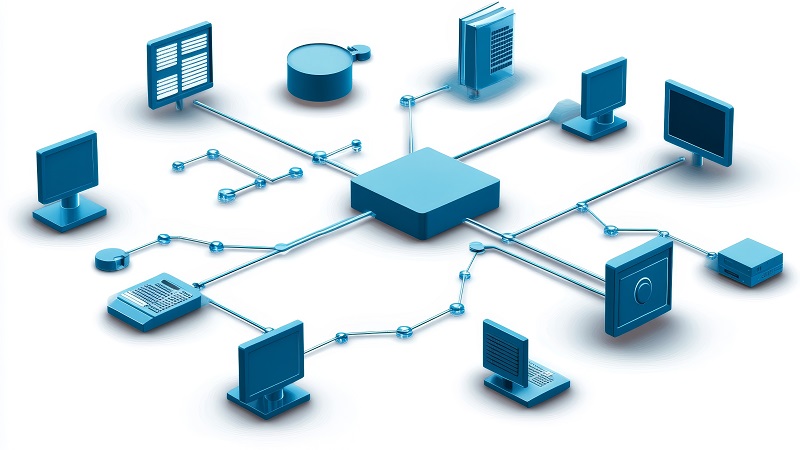

データ統合とは自社の異なるデータソースに散在しているデータを集約し、単一のデータセット(一定の形式に整理されたデータの集合体)に統一することです。

データ統合により社内に存在するデータを一元管理することで、データの断片化や分散を解消し、会社全体で統一されたデータベースを共有できます。また、集約したデータをグラフ、チャート、ダッシュボードなどに落とし込んで可視化することで、データを誰でも容易に把握できる状態になります。

データ統合が済んでいない状態でデータを閲覧・分析しようとすると、点在するデータベースに個別にアクセスしなければならず効率が悪化します。また、データベースによって使用されている言語が異なると、一部の高いスキルを持つ人以外は取得することさえ難しいでしょう。

上記のように、データ統合によって異なるデータソースからのデータが一元化されることで、従業員がデータを探索する時間が削減され、常に最新のデータにアクセスできるようになります。より迅速な意思決定を行うためにも、データ統合は必要不可欠です。

データ統合のメリット

前章では、データ統合によりデータの全容把握が容易になり、データ探索時間の削減も実現できることを解説しましたが、以下ではデータ統合のさらなるメリットについて詳しくご紹介します。

データのサイロ化を防ぐことができる

データのサイロ化とは、異なる部門間でシステムが分断されてしまい、連携が取れていない状態のことを指します。

データ統合により、異なる部門やシステムに散在しているデータを一元的に管理できるようになるため、データのサイロ化を解消できます。サイロ化の解消を通じて、必要なデータや足りないデータなどを容易に把握できるようになることもメリットです。

データ管理コストを削減できる

データを一元化することで、データ管理担当者の負担が軽減されます。散在するデータを整理・加工するためには膨大な工数がかかり、人的ミスも起きやすくなりますが、データ統合によってそうした課題を解消でき、生産性向上に寄与します。

AIを活用した高度な分析ができる

複数のデータソースからのデータが統合されることで、データの一貫性が保たれるようになります。これにより、データ分析を通じて信頼性の高い結果を提供しやすくなることもメリットの1つです。データの完全性が向上し、データの欠損や矛盾も減少します。

さらに、多くのデータを統合することで相関関係やパターンを発見しやすくなり、より包括的な分析が可能となります。

経済産業省のDX推進ガイドラインでは、DXを「企業がビジネス環境の激しい変化に対応し、データとデジタル技術を活用して、~競争上の優位性を確立すること」と定義しており、DXを推進するうえでもデータの活用は必須です。

出典:経済産業省(2020年11月9日策定・2022年9月13日改訂)「デジタルガバナンス・コード2.0 」

昨今では、データ分析にAIを活用している企業も少なくありません。データ統合を行うことで組織内の多様なデータをビッグデータとして活用することができ、AIはそのビッグデータを取り込むことでより正確で示唆に富むデータ分析結果を示すことができるようにもなります。

▼関連記事はこちら

データ分析基盤とは?構築するうえで知っておきたい4つのポイント

【AI分析活用事例をご紹介】業務効率化だけではない!AI分析がビジネスにもたらす可能性

次章では、データ統合を実施する際の流れを解説します。

データ統合の具体的なステップ

データ統合は、具体的には以下のステップを踏んで進めていきます。

①統合対象の決定

まずは社内システム等に存在するデータをリスト化し、どこにどのようなデータが存在するのか把握したうえで、統合する対象を決めます。基幹システムだけでなく、サブシステムを含め部門で個別に保有するデータも統合対象として精査することが必要です。

たとえば製品・サービスのマスタデータ、CRMシステムに集約されている顧客データ、業務アプリのトランザクションデータなどが対象となります。

データ統合の対象によって、利用するデータリポジトリがデータレイクか、データウェアハウスか、データマートかが変わってきます。

②データクレンジング

統合するデータの対象を決めたら、データを扱いやすいように処理する必要があります。そのプロセスをデータクレンジングといいます。データクレンジングはデータの重複や欠損、粒度の違いなどデータの不備を適切な形に修正することであり、システムの統合に伴うデータ移行時に不可欠です。

データクレンジングの詳細についてはこちらの記事をご覧ください。

- データ分析・データ移行に必要なデータクレンジングは効率化が課題?解決策をご紹介

- データクレンジングとは、データ分析やデータ移行に不可欠な作業です。実際に行う場合、高度な知識や技術が必要な場合もあり、変換の際に膨大な待ち時間がかかるケースがあります。本記事では、データクレンジングが必要とな…

③データの変換・加工

データクレンジングの後に行う工程が、データの変換・加工です。このステップでは、データのフォーマットを統一します。たとえば、文字コードが複数あると文字化けが発生する可能性があるので注意が必要です。日付の桁や通貨単位なども統一しておきます。

データリポジトリに移行後は、扱いやすくするためにデータ粒度の統一や結合・分割などの加工処理も行います。

④データの収集

変換・加工後には、データの収集方法を決定し、実際にデータを集めていきます。データ統合で使用される集積方法にはデータレイク、データウェアハウス、データマートがあり、データ活用の目的によって最適なものが異なります。

データレイク・データウェアハウス・データマートそれぞれの違いについては、こちらの記事をご覧ください。

- データレイク、データウェアハウス(DWH)、データマートの違い、メリット・デメリットを紹介!

- ビッグデータをはじめ、膨大かつ多様な情報が存在する現在、データを効果的に活用・分析することが企業には求められています。そこで重要になるのがデータ分析基盤の構築です。本記事では、データ分析基盤を構成するデータレ…

データ統合の課題

データ統合には以下のような課題があり、実施する際には注意が必要です。

異なるデータソースに対応できない

複数のデータソースがそれぞれ異なるフォーマットや構造を持つ場合、これらを統合することが難しくなります。データの整形や変換が必要となり、その過程で統合したいデータが失われる可能性があるほか、データの品質が不均一となってしまうことにも注意が必要です。

大量のデータ処理に時間がかかる

近年のシステムはデータの量が膨大なものになっており、大量のデータ処理に時間がかかることも課題です。特に画像や動画など容量の大きいデータを活用する際には、どのようにデータ処理をスピーディーに進めていくかが問われます。

データ統合の課題を解決するプラットフォームのご紹介

前章でご紹介したような課題を解決できるソリューションとして、LaKeel Data Insight(LDI)があります。

LaKeel Data Insightは、企業の内外に点在する大量のデータを継続的に収集・集約し、業務担当者が多様なデータを活用した多角的な分析を行えるよう支援するシステムです。源泉に近いデータレイクから、利用者に近いデータマートまで一元的に管理し、データを可視化しやすい状態を構築します。

LaKeel Data Insightなら大量のデータ処理を高速で実施することができ、自由に検索し加工することが可能です。また、グラフィカルな画面操作のみで、外部からのデータ取込・クレンジングなどのデータ加工・データ出力といった処理が定義可能であり、「異なるデータソースに対応できない」という課題にも対応できます。

- LaKeel Data Insight

- LaKeel Data Insightは、企業内外に点在する大量のデータを継続的に収集・集約し、業務担当者が様々なデータを活用した多角的な分析を行い、ビジネスに有益に活かす活動を支援するシステムです。

下記の資料では、データ統合を含むデータの収集、蓄積、加工、分析を一貫して対応できる「データ分析基盤」の構築のポイントを解説していますので、ぜひご覧ください。

- お役立ち資料

- データ分析基盤構築ガイドブック

このコラムを書いたライター

本サイトでは、企業のDX推進に役立つ様々な情報をお届けしています。